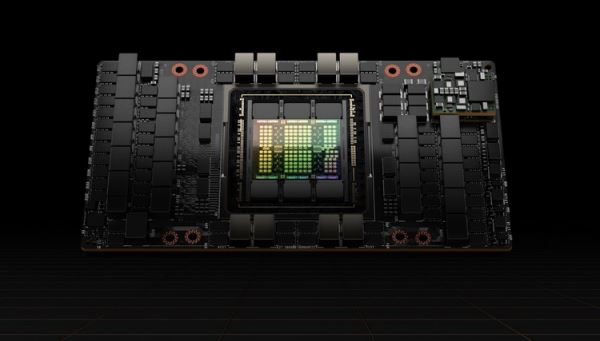

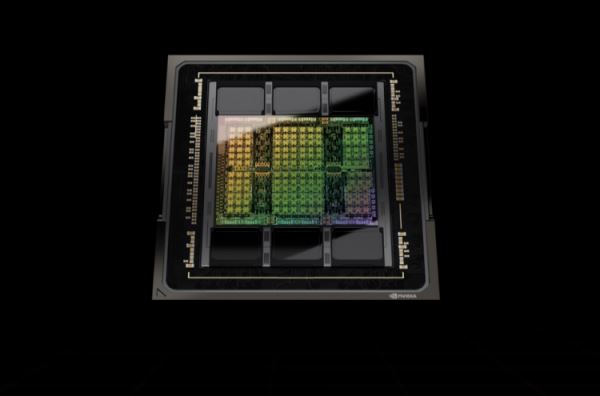

В ходе мероприятия GTC 2022 компания NVIDIA анонсировала новую графическую архитектуру Hopper и первые продукты на её базе — ускорители вычислений H100. Их чипы с прядка 80 млрд транзисторов и производятся по техпроцессу TSMC N4 (улучшенные 5 нм).

Источник изображений: NVIDIA

Компания заявляет о трёхкратном увеличении производительности в операциях FP64, TF32, FP16 и шестикратном росте быстродействия в операциях FP8 у H100 по сравнению с NVIDIA A100.

В состав H100 также входят 80 Гбайт памяти HBM3 с пропускной способностью 3 Тбайт/с, что в 1,5 раза больше в сравнении с актуальным ИИ-ускорителем NVIDIA A100.

Ключевыми особенностями ускорителей NVIDIA H100 являются новый движок Transformer Engine, поддержка специальных DPX-инструкций для динамического программирования, второе поколение технологии виртуализации Multi-Instance GPU, поддержка 4-го поколения шины NVLink со скоростью передачи данных 900 Гбайт/с и новый коммутатор NVSwitch, который позволяет напрямую объединить между собой до 256 ускорителей. Обо всех этих нововведениях можно более подробно ознакомиться в статье наших коллег из ServerNews.

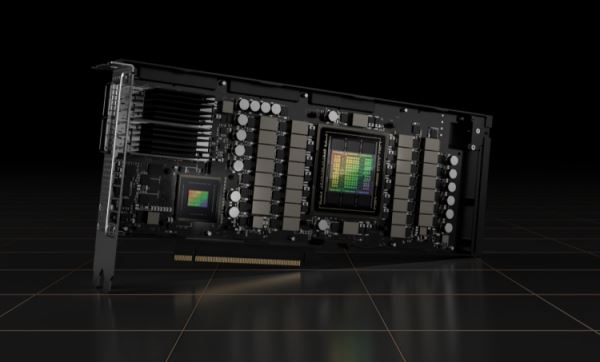

Ускорители вычислений NVIDIA H100 будут выпускаться как в формате карт расширения PCI Express 5.0 с показателем TDP на уровне 350 Вт, так и в форм-факторе SXM5 с заявленным TDP 700 Вт, что на 300 Вт больше, чем у A100. При этом PCIe-версия получит менее мощный чип с 14 592 ядрами CUDA. Модель в формате SXM5 будет построена на чипе с 16 896 ядрами.

Компания сообщает, что первыми продуктами на базе ускорителей H100 станет четвёртое поколение систем DGX — DGX H100, которые смогут обеспечивать до 32 Пфлопс производительности в вычислениях ИИ в операциях FP8. Партнёры предложат HGX-платформы на 4 или 8 ускорителей. Наличие четвёртого поколения шины NVLink Switch позволит объединять в сети до 32 систем DGX H100, образуя на их основе суперкомпьютеры NVIDIA DGX SuperPOD нового поколения. Сама NVIDIA сейчас занимается созданием суперкомпьютера EOS, который будет состоять из 576 систем DGX H100 и получит FP64-производительность на уровне 275 Пфлопс, а FP16 — 9 Эфлопс.

Новой архитектурой Hopper уже заинтересовались ведущие провайдеры облачных сервисов, такие как Alibaba Cloud, Amazon Web Services, Baidu AI Cloud, Google Cloud, Microsoft Azure, Oracle Cloud и Tencent Cloud, которые планируют использовать в своих экосистемах решения на базе ускорителей NVIDIA H100.

Источник: 3dnews.ru